آموزش ساخت فایل robots.txt

فایل robots.txt (رباتس)چیست و کاربر فایل robots چیست؟

فایل رباتس robots,.txt یکی از فاکتور های مهم سئو تکنیکال است وقتی خزنده گوگل به سایت ما سر میزند قبل از هر چیزی فایل رباتس robots.txt را بررسی میکند و تنها فایل هایی را ایندکس میکند که در فایل رباتس اجازه دسترسی صادر شده باشد. در حقیقت استاندارد Robots Exclusion یک ابزار قدرتمنداست که با استفاده از آن میشود به موتورهای جستجو اعلام کرد کدام قسمتهای یک سایت رو کراول کنند و با کدام قسمت ها کاری نداشته باشند.

ما در این آموزش به شما صفر تا 100 نحوه نوشتن دستورات فایل robots و نحوه ساخت فایل رباتس در هاست و مزایای آن به خصوص در سئو میپردازیم. این آموزش از سری سرفصل های آموزش گوگل سرچ کنسول است دوست داشتید این آموزش زا نیز مشاهده فرمائید

اهمیت داشتن فایل robots.txt

در مورد اهمیت فایل رباتس باید گفت فرض کنید دفعه اول است که وارد یک سازمان عظیم شوید اگر قسمت اطلاعات و افرادی وجود نداشته باشد شما نمیدانید کجا بروید مرتب بالا و پایین میروید تا به مکان دلخواه خود برسید اگر این افراد راهنما و نگهبان نباشند، کل سازمان دچار هرج و مرج میشود. هرکسی برای انجام کارهایش راهروها را بالا و پایین میکند و کارمندان هم نمیتوانند کارها را به درستی انجام دهند. فایل Robots.txt در وبسایتها نقش همین راهنماها و نگهبانان را برای رباتهایی که برای بررسی سایت یا هر کار دیگری میخواهند در بخشهای مختلف سایت سرک بکشند دارند.

آشنایی با انواع فایل رباتس robots.txt

User-agent – برای یک موتور جستجو یک قانون تعریف می کند.

Disallow – به موتور جستجو میگوید که یک فایل، صفحه یا دایرکتوری رو crawl و index نکند.

Allow – به یک موتور جستجو اعلام میکند که یک فایل یا دایرکتوری رو ایندکس کند.

Sitemap – موقعیت قرار گرفتن فایل سایت مپ شما رو مشخص می کند.

Crawl-delay – زمان بین ارسال درخواست ها به سرور رو بر حسب ثانیه مشخص می کند.

User-agent: *

این دستور به معنای صدا زدن تمام ربات ها اعم از گوگل- یاهو – بینگ و … است.

Disallow: /wp-admin/

این دستور یعنی به پوشه wp-admin سر زده نشود.

Disallow: /wp-includes/

این دستور یعنی به پوشه wp- include سر زده نشود.

Disallow: /wp-content/plugins

این دستور یعنی به پلاگین ها سر زده نشود

Disallow: /wp-content/themes

این دستور یعنی به قالبها سر زده نشود.

موتور جستجوی بینگ: Bingbot

موتور جستجوی گوگل: Googlebot

موتور جستجوی تصویری گوگل: Googlebot-Image

موتور جستجوی خبری گوگل: Google-News

موتور جستجوی Ask: Teoma

User-agent: Googlebot

این دستور فقط ربات های گوگل را صدا میزند

Disallow: /panel/

Allow: /panel/frontend.php

برای محدود کردن به دسترسی به یک فایل میتونید تا به شکل زیر عمل کنید.

Disallow: /images/dogs.pdf

Disallow: /readme.html

Disallow: /

دستور بسیار خطرناکی است سایت را از بین میبرد.

Disallow: /*?

دستور زیر را به شکل موقت درج میکنید تا رباتها آدرسهای دارای کاراکتر علامت سؤال را ایندکس نکنند.

Disallow: /*?$

ا درج $ تأکید میکنیم که اگر در انتهای آدرسی علامت سوال (?) بود، آن آدرس باید Disallow شود

Disallow: /*brand

Disallow: /*price

Disallow: /search

Disallow: /compare

Allow: /product

Allow: /wp-admin/admin-ajax.php

Sitemap: https://pishtazwebwp.com/sitemap_index.xml

مشخص کردن سایت مپ به موتورهای جستجو کمک می کند تا سریعتر نقشه سایت شما را دربیارند و بتوانند محتواهای سایت رو سریعتر شناسایی و ایندکس کنند.

مزایای استفاده از فایل رباتس robots.txt

1-جلوگیری از ایندکس مطالب کپی و جلوگیری ازگرفتن رتبه منفی برای سایت

2- جلوگیری از ایندکس مطالب اضافی و به درد نخور و خصوصی سایت

3- بهبود سئو سایت با کاهش فایل های اضافه و افزایش سرعت

با بهینه سازی فایل Robot.txt به راحتی میتوانید به رباتهای جستجو دستور دهید که فقط صفحات ضروری را پیمایش کنند و از ایندکس کردن صفحات غیرضروری خودداری کنند، با این کار سرعت پیمایش وبسایت توسط رباتهای جستجو تا اندازه قابل توجهی افزایش مییابد و در نتیجه سایت رتبه بالاتری کسب میکند.

4-مدیریت ترافیک رباتها به وبسایت با افزایش بودجه خزش سایت

مدیریت ترافیک رباتها از این جهت اهمیت دارد که سرور میزبان وبسایت شما برای پردازش و بارگذاری صفحات برای رباتها مشغول نشود. از طرف دیگر، اکثر سرورها یا میزبانهای وبسایت از نظر پنهای باند و ترافیک محدودیت دارند؛ به همین دلیل مصرف ترافیک برای رباتها مقرون به صرفه نیست.

نمونه کد های قابل استفاده در فایل robots.txt (فایل رباتس)

https://www.google.com/robots.txt

و یا کد هایی به شکل زیر را استفاده کنیم

User-agent: *

Disallow: /wp-admin/

البته جدیدا فایل wp-includes را بهتر است نبندید

Disallow: /wp-includes/

Disallow: /wp-content/plugins/

Disallow: /wp-content/themes/

Disallow: /xmlrpc.php

Disallow: /test-download-urls

Disallow: /shortcode-test

Disallow: /checkout

Disallow: /checkout/pay

Disallow: /checkout/order-received

Disallow: /my-account/downloads

Disallow: /my-account/view-order

Allow: /wp-admin/admin-ajax.php

Disallow: /cart

Disallow: /readme.html

Disallow: /products/

Disallow: /api/

Disallow: /demoimport/

Disallow: /demo/

Disallow: /*?min_price

Disallow: /*?orderby

Disallow: /*?filter_

Disallow: /wishlist

Disallow: /compare

Sitemap: https://example.com/sitemap.xml

نحوه ساخت فایل robots.txt:

1-ساخت فایل رباتس robots.txt به صورت دستی

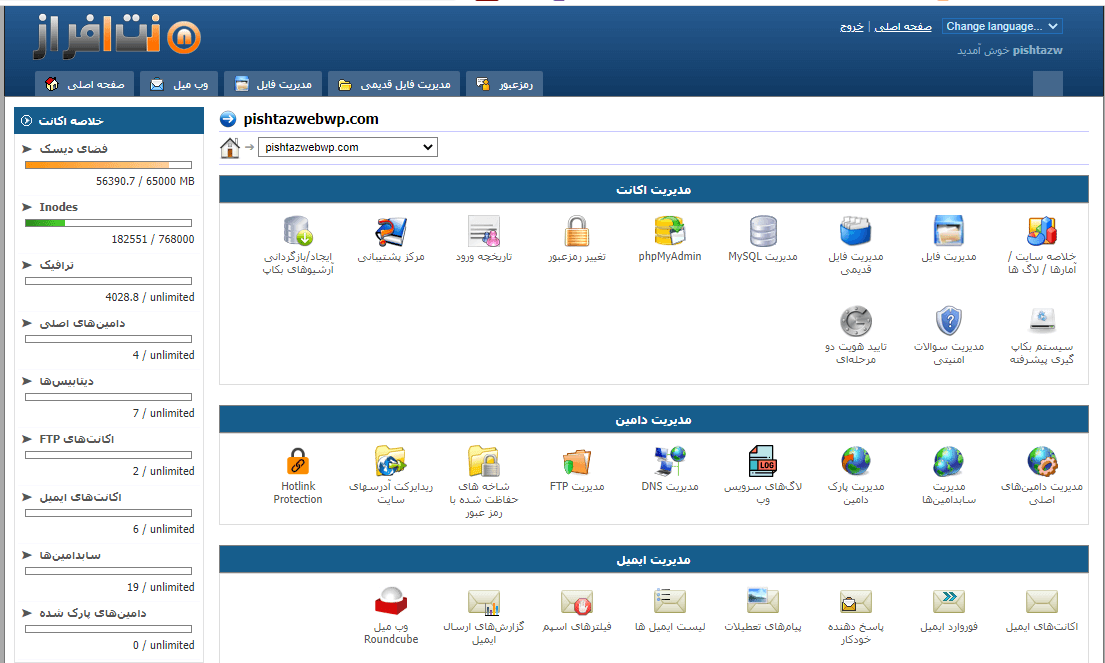

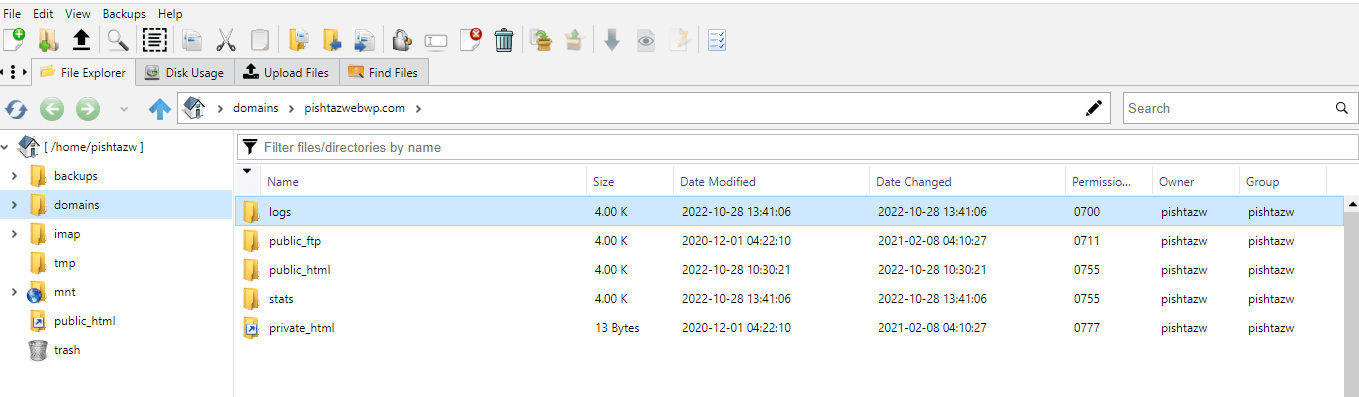

برای ساخت فایل رباتس robots.txt اخل دایرکت ادمین ابتدا وارد هاست شده سپس گزینه ی مدیریت فایل را میزنیم تا به فایل منیجر هاست هدایت شده و بتونید فایلهای موجود در هاست را کنترل کنید.

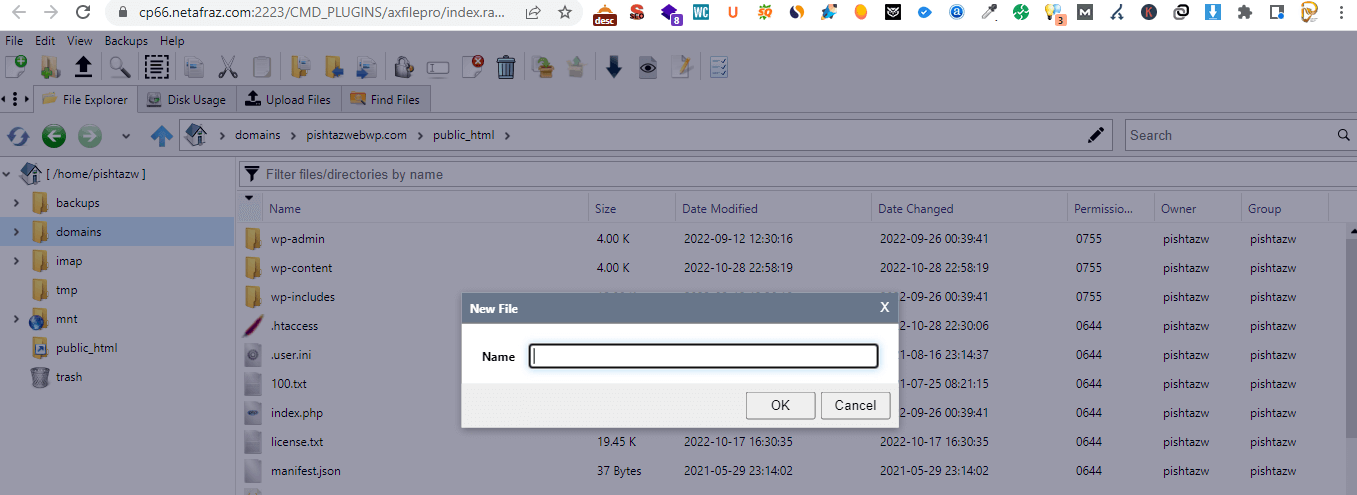

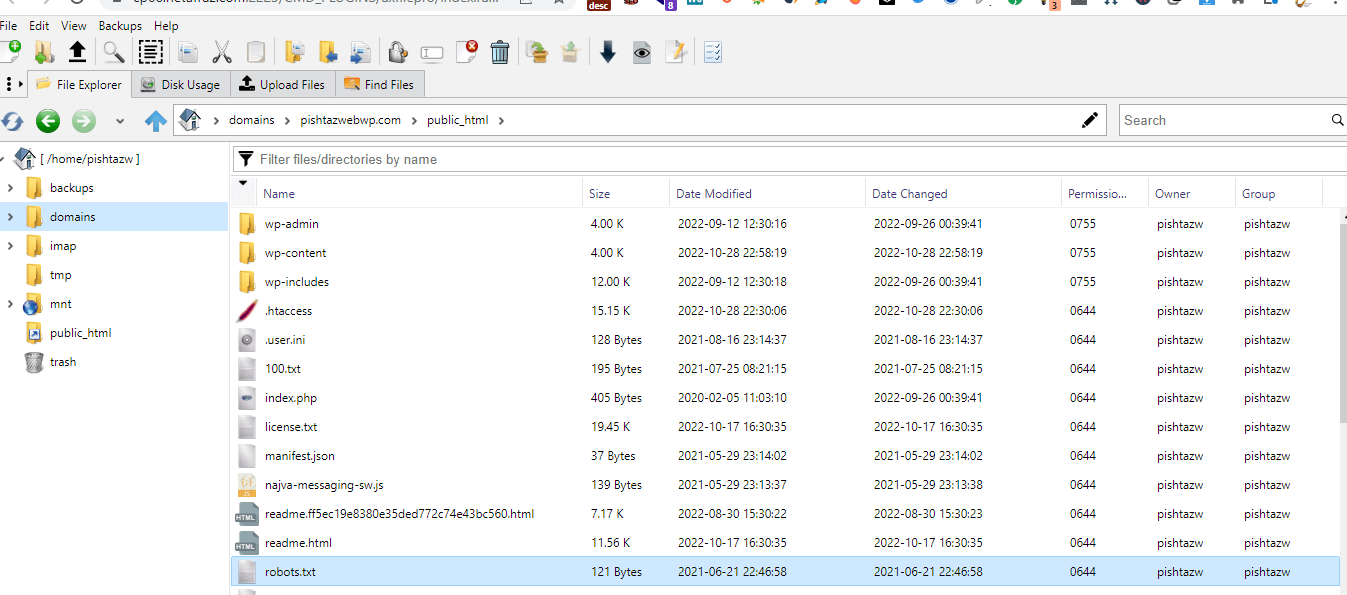

پس از آن به مسیر /public_html/ مراجعه کنید تا به مسیری که وردپرس در آنجا نصب هست برسید. اگر وردپرس شما روی دامنه اصلی شما نصب شده باشد کافیه توی همین مسیر باشید اما اگر در پوشه جدایی اونو نصب کردید باید وارد همون پوشه از هاست خودتون بشید.

سپس فایل تکستی که توسط notpad یا هر ویرایشگر متنی ساخته اید و کد ها را داخل آن قرار داده اید در این قسمت قسمت فایل آپلود کنید و اسم آن را robots.txt بگذارید

وقتی فایل را آپلود میکنید به شکل زیر در این آدرس قرار خواهد گرفت.

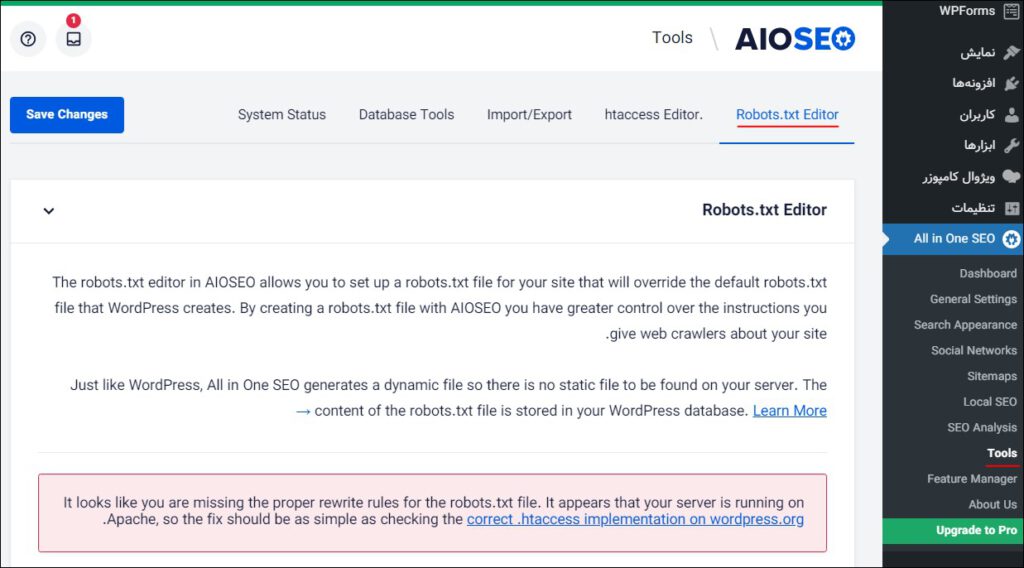

2-ساخت فایل رباتس robots.txt با افزونه All in One SEO

All in One SEO که با نام AIOSEO نیز شناخته میشود که با بیش از 2 میلیون نصب فعال جزو محبوبترین افزونهها برای سئو و بهینهسازی وبسایت میباشد. این افزونه با طراحی کاربری بسیار آسانی که دارد برای مبتدیان بهترین گزینه بشمار میآید و به همراه یک فایل robots.txt ارائه میشود که با کمک آن میتوانید فایل robots.txt را به طور مستقیم ایجاد و ویرایش کنید. پس از نصب و فعالسازی افزونه، گزینه Tools را از منوی All in One SEO انتخاب کنید تا صفحه زیر برای شما نمایان شود:

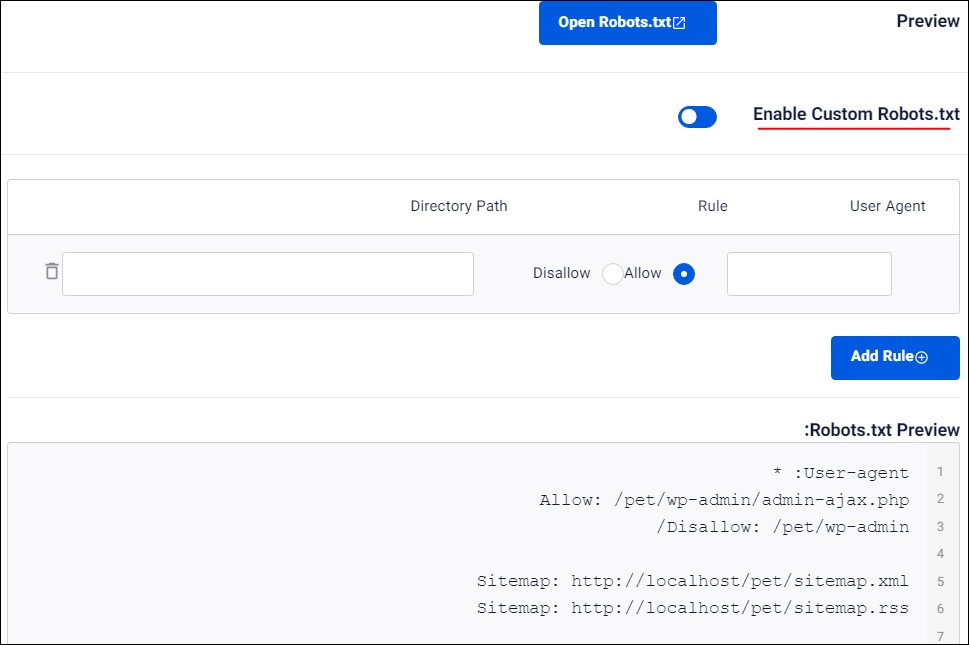

در مرحله بعد لازم است گزینه Enable Custom Robots.txt را فعال کنید. با فعال کردن این گزینه یک فایل سفارشی robots.txt در وردپرس ایجاد خواهد شد.

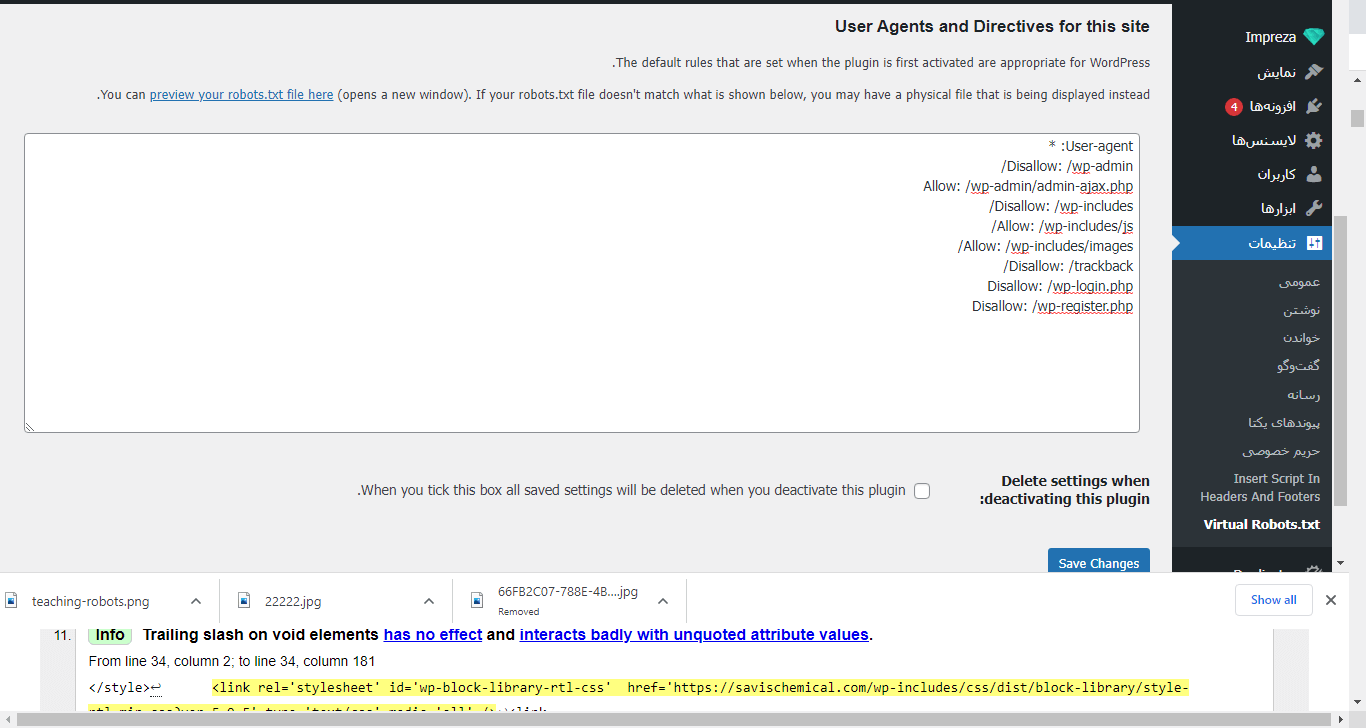

3-ساخت فایل رباتس robots.txt با افزونه virtual robots.txt

از کجا فایل رباتس را ببینم؟

https:// yourdomain/robots.txt

https://pishtazwebwp.com/robots.txt

آزمایش درستی فایل robots.txt به دو شکل زیر امکان پذیر است

https://sitechecker.pro/robots-tester/

https://www.google.com/webmasters/tools/robots-testing-tool

تفاوت فرق متاتگ Robots با فایل Robots.txt

1- فایل robots.txt به شکل یک فایل واقعی در چنین آدرسهایی www.domain.com/robots.txt قراردارند. ولی متاتگ robots به صورت تگ و قبل از head نیز وجود دارند

<head>

<META NAME=”ROBOTS” CONTENT=”NOINDEX, NOFOLLOW”>

</head>

2-توسط دستور robots.txt شما میتوانید صفحات بسیاری را برای رباتها و موتورهای جستجو مسدود کنید ولی با متاتگ robots چنین عملی را اگر بخواهید انجام دهید باید در تکتک آن صفحات نیز متاتگ را درج کنید.

3-توسط فایل robots.txt شما میتوانید سایت مپ سایت را به رباتها و موتورهای جستجو معرفی کنید ولی با متاتگ امکانپذیر نیست.

4- انعطافپذیری دستورات متاتگ robots بیشتری نسبت به فایل robots.txt بیشتر است.

5-با اینکه توسط فایل رباتس دسترسی را بسته ایم گاهی در نتایج دیده میشود بهتر است توسط متا تگ هم بسته شود.

سوالات متداول فایل رباتس(فایل robots.tx)

آیا اسم فایل ساخته شده حتما بایدrobots.txt باشد؟

بله تنها این نام قابل پذیرش است.

فایل رباتس robotos.txt کجا هست؟

داخل هاست و قسمت public html

آیا فایل robots حتما باید txt باشد؟

بله برای ساخت فایل robots.txt فقط یک فایل txt جدید ایجاد کنید. فرمت یا انکودینگ فایل حتماً باید UTF-8 باشد.

آیا اندزه فایل robots رباتس محدودیت اندازه دارد؟

این فایل نباید بیشتر از 5000 کاراکتر باشد. اگر به طور متوسط هر خط کد رو 25 کاراکتر در نظر بگیریم، این تعداد کاراکتر حدود 200 خط دستور میشود

آیا ساخت فایل رباتس robots.txt برای هر سایتی ضروری است؟

خیر اما برای کمک به بهبود سئو مخصوصا در سئو تکنیکال بهتر است از ان استفاده شود.

اگر فایلی داراری تگ کنونیکال باشد توسط رباتس هم حذف شده باشد آیا در نتایج جستجو دیده میشود؟

بله دیده میشود

قطع دسترسی رباتهای گوگل برای خزش فایلهای css، js، html مشکلی دارد؟

بله نتیجه منفی دارد.

نتیجه گیری

در این آموزش در مورد اهمیت ساخت فایل رباتس robots.txt صحبت کردیم و به شما یاد دادیم که چطور میتوانید با نوشتن دستورهایی ساده در یک فایل به نام Robots.txt جلوی ورود ربات را به بخشهایی از سایت را بگیرید و به آنها بگویید اجازه ندارند وارد بخشی از سایت شوند یا دستوراتی خاص بدهید تا سرور میزبان سایت شما الکی مشغول رباتها نشود و با اینکار چطور باعث افزایش و بهبود سئو سایت خود شوید.

این آموزش از سری سرفصل های آموزش گوگل سرچ کنسول است دوست داشتید این آموزش زا نیز مشاهده فرمائید.

امیدواریم این آموزش به درذ شما خورده باشد همانطور که گفتیم این آموزش هایش از سری آموزشهای سئو تکنیکال است اگر به سئو علاقه مندید میتوانید مقاله آموزشی سئو و بهینه سازی سایت را مشاهده کنید.

19 دیدگاه. ارسال دیدگاه جدید

مرسی از اموزش خوبتون برقرار باشید

برقرار باشید

سلام مرسی از آموزش خوبتون آموزش فایل رباتس در کدوم قسمت سئو به درد میخورد؟

سلام روز بخیر در سئو تکنیکال کاربرد دارد

ممنون

موفق باشید

ابزا های سئو هم آموزش داد میشه؟

سلام روزتون بخیر بله حتما در آموزش جامع ابزار سئو میتوانید با آنها آشنا شوید

نحوه ساخت فایل robots.txt به نظر شما به روش دستی بهتره یا با افزونه؟

سلام ساخت فایل robots.txt به روش دستی بهتر هست چون افزونه ها سرعت را پایین میآورند

سلام نحوه ساخت فایل robots.txt را بسیار خوب توضیح داده بودید -ممنونم

سپاس از شما خوشحالیم که از آموزش ساخت فایل رباتس robots.txt رضی بودید موفق باشید

نحوه ساخت فایل robots.txt خوب بود ساخت فایل robots.txt جز کدام موارد سئو قرار میگیرد؟

با سلام خدمت شما ساخت فایل robots.txt جز سئو تکنیکال است

ایا نحوه ساخت فایل robots.txt را با هوش مصنوعی هم میشه انجام داد؟

سلام خب بله میشه از chatgpt بخوای که با هوش مصنوعی دستورات فایل robots.txt را بهتون بگه البته شاید دقیق نباشه چون از کسب و کار به کسب و کار دیگه ممکنه متفاوت باشه

نحوه ساخت فایل robots.txt را خیلی خوب توضیح دادید ممنون از شما و گروهتون

ر

خواهش میکنیم فایل رباتس یک فایل مهم است در سئو

به نظر شما ما فایل های فیلتر را در فایل رباتس ببنیدیم یا خیر؟